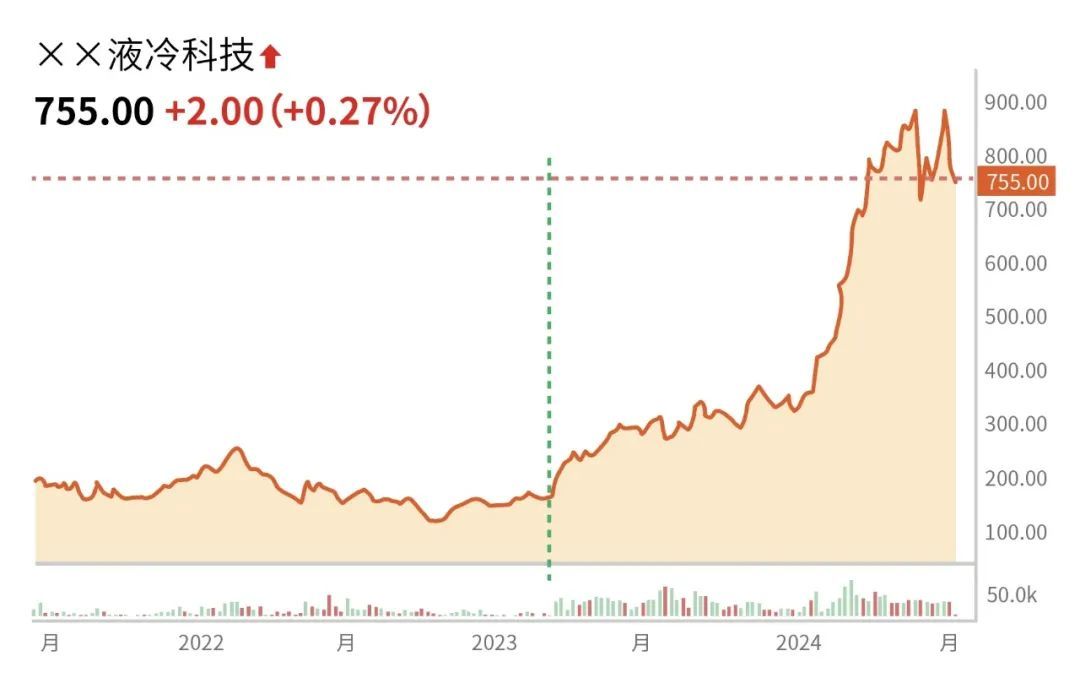

2022年底OpenAI引发AI热潮,液冷相关话题也随之“风起云涌”:

2024年英伟达发布NVL72/NVL36方案,进一步推高全液冷数据中心的建设需求。

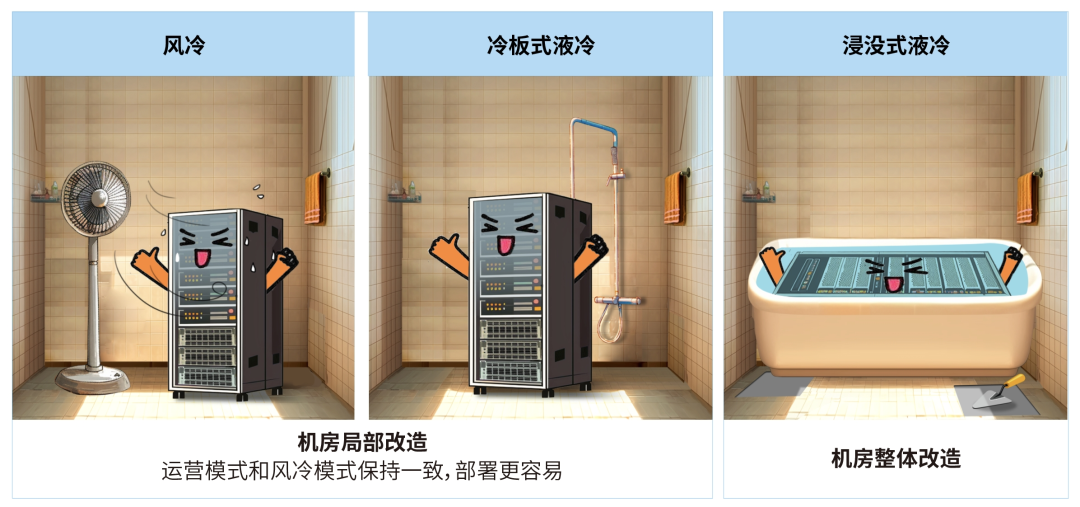

数据中心领域大规模在用的液冷主要有冷板、浸没两种,其他如喷淋等未规模部署:

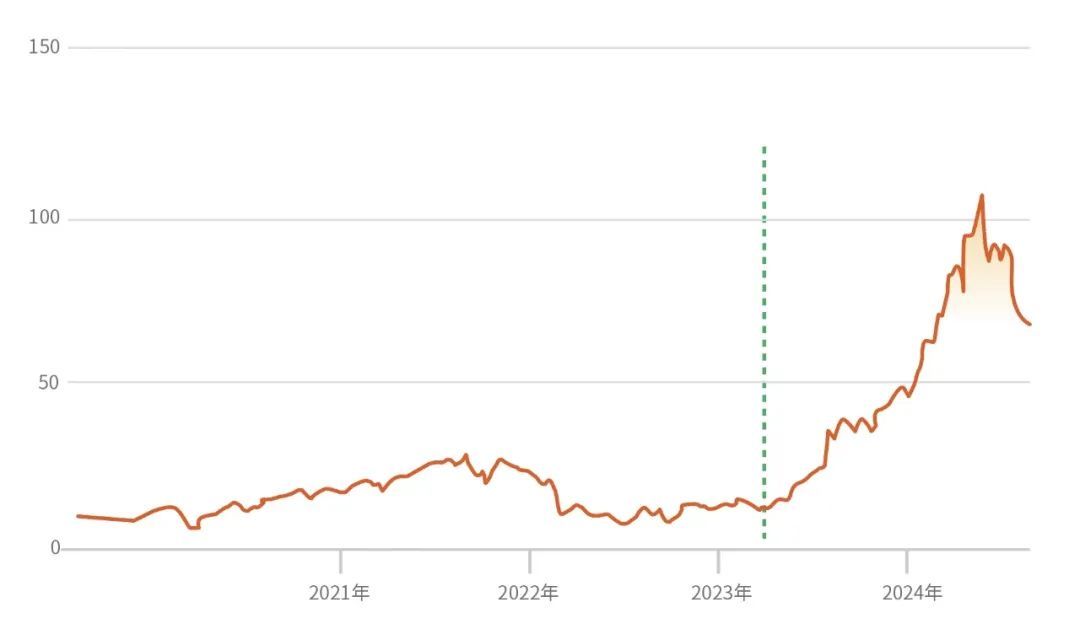

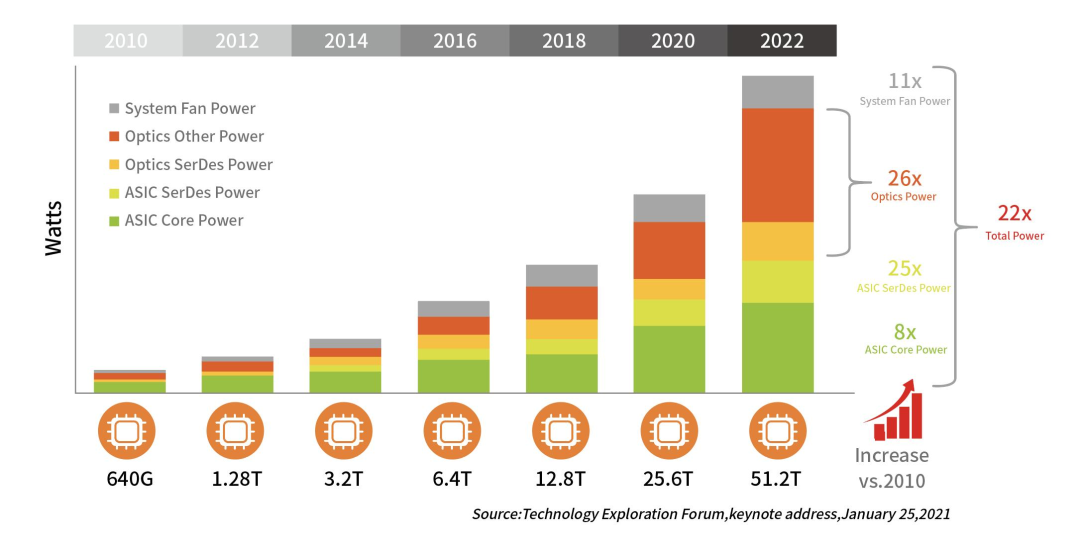

为什么交换机需要液冷?

“和尚关注念经,道士关心养生”,网络关注交换机液冷,服务器关心GPU液冷:

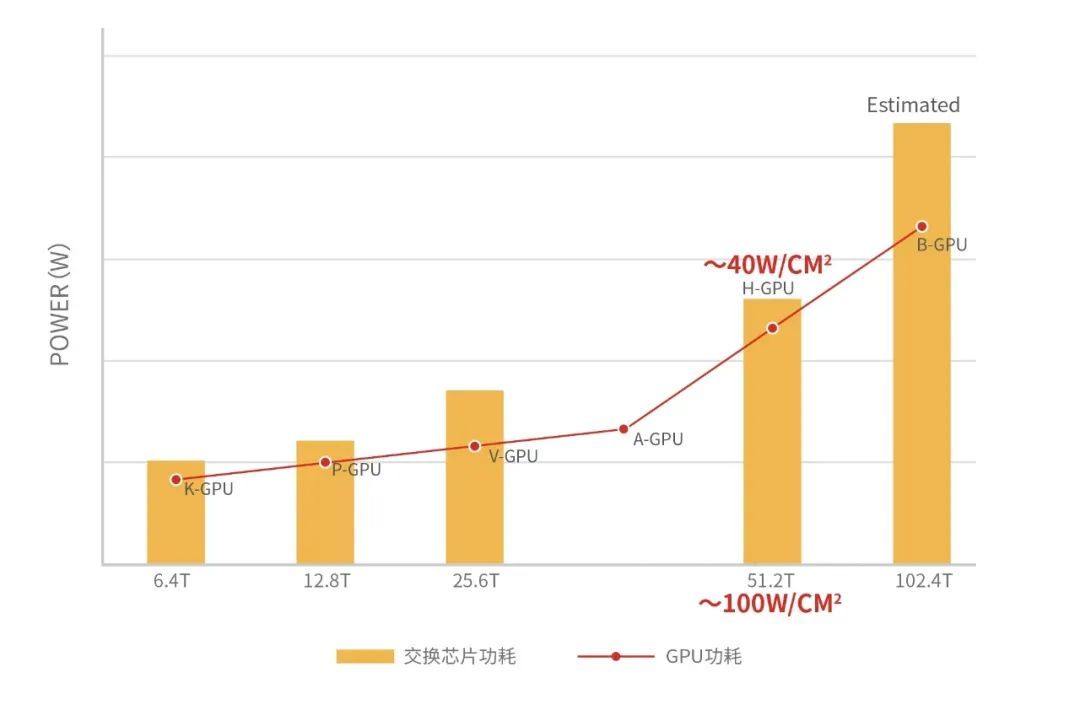

12年间典型交换机system功耗增长22倍,Optics增长26倍,ASIC Serdes增长25倍,功耗增长速度超过风冷散热能力提升速度。

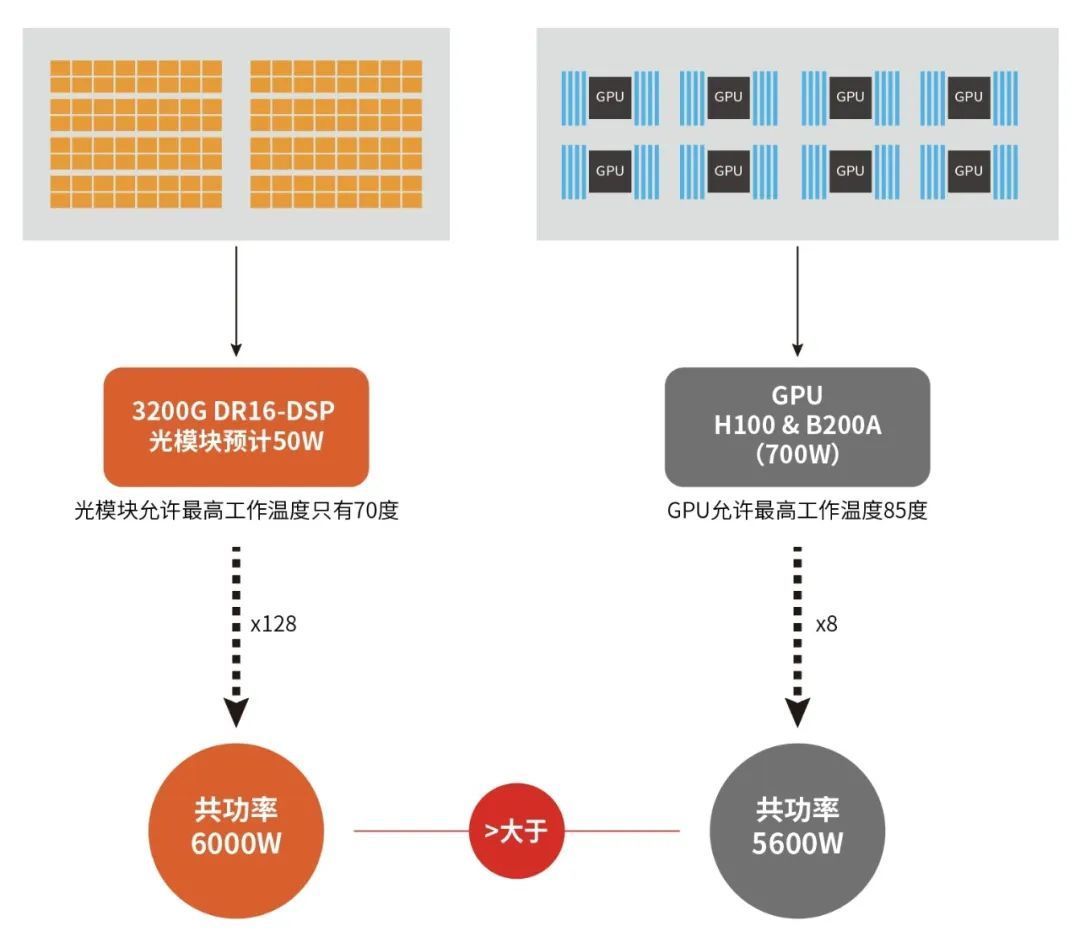

交换机液冷需求1:128 x 3.2T DR16-DSP设备为例,光模块功耗大于GPU,耐温低于GPU,可增加散热器空间远小于GPU。

交换机液冷需求2:交换芯片功耗和热流密度均大于GPU。

液冷交换机设计三难

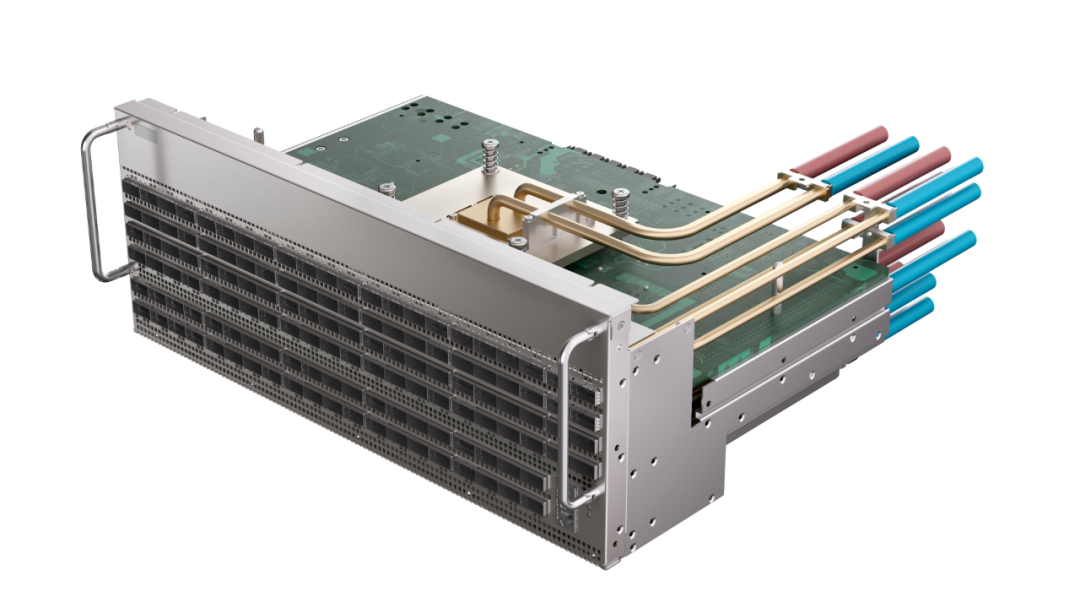

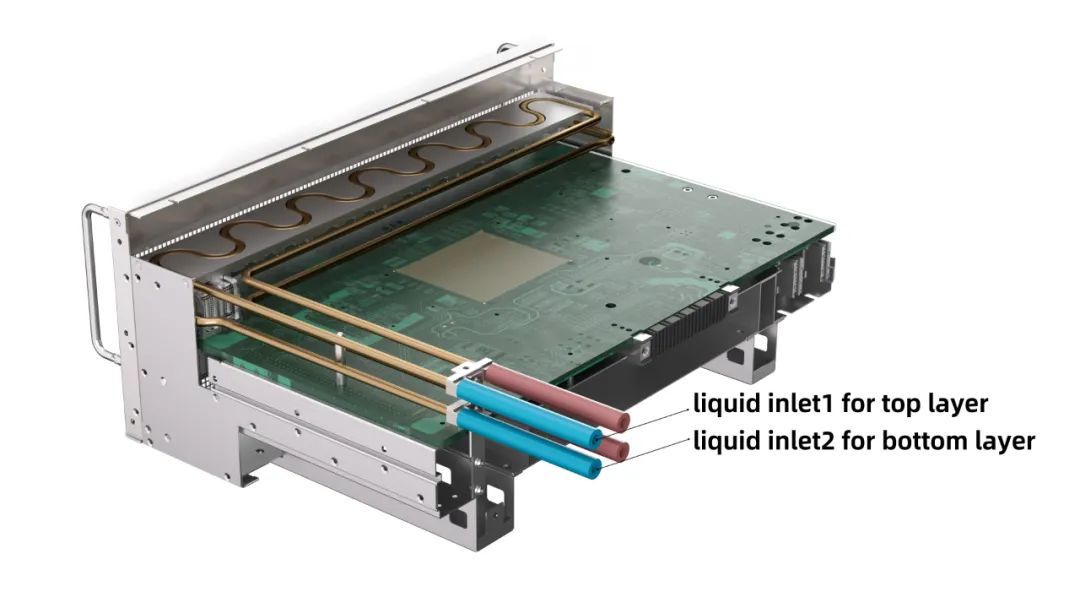

难点1:交换机冷板系统属于“三维”组装,GPU液冷冷板系统属于“二维”组装,三维难度远大于二维。

难点2:硬件不可能不坏,液冷亦如此,单台交换机宕机影响远大于单台服务器,如何实现即使漏液单台交换机“不宕机”。

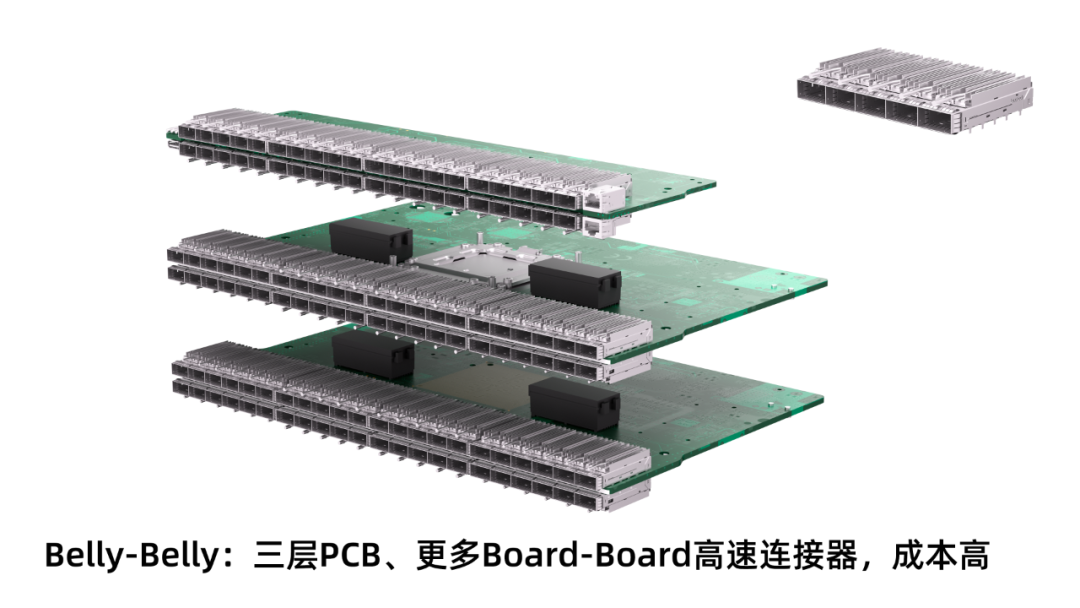

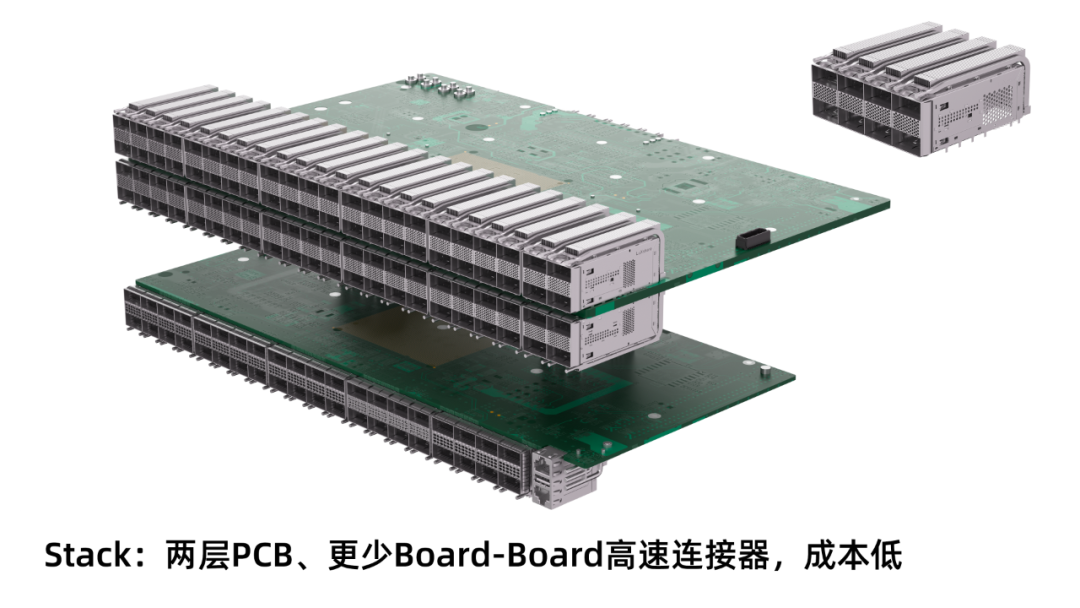

难点3:Belly-belly optics冷板设计较容易,系统成本更高,stack opitcs方案成本更低,但是截止2024年前,市面上没有bottom optics in stack cage冷板方案可用。

阿里/锐捷联合开发Liquid Tigatron交换机

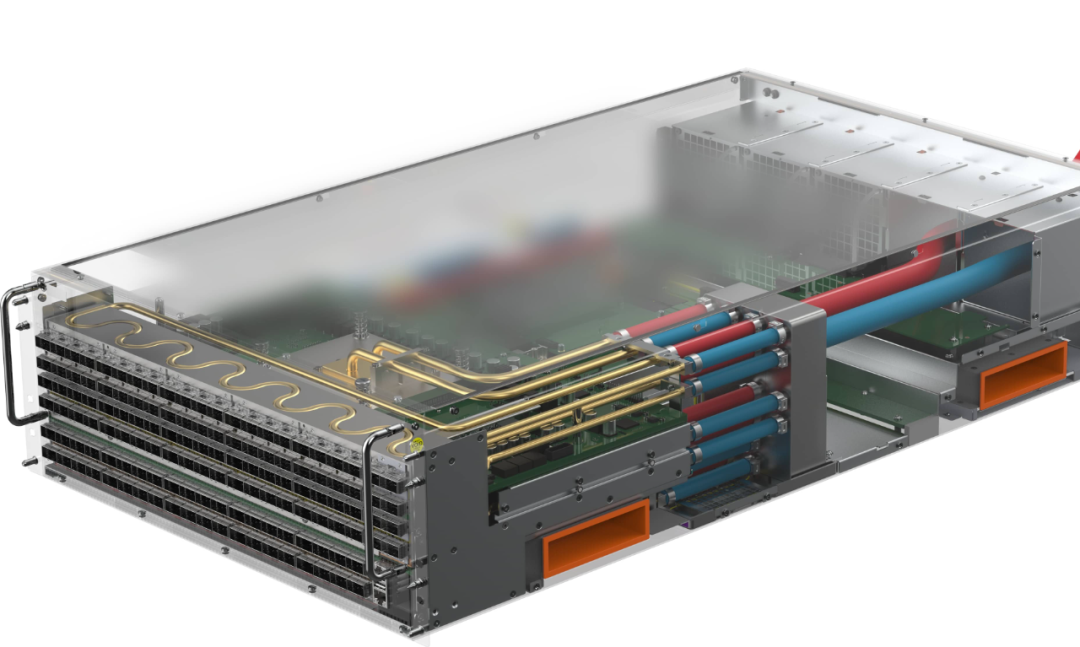

针对难点1:基于S³IP UNP理念定制自动化液冷组装平台,已通过批量交付验证,可实现TH5 Tigatron交换机液冷套件的“三维”快速组装和气密测试。

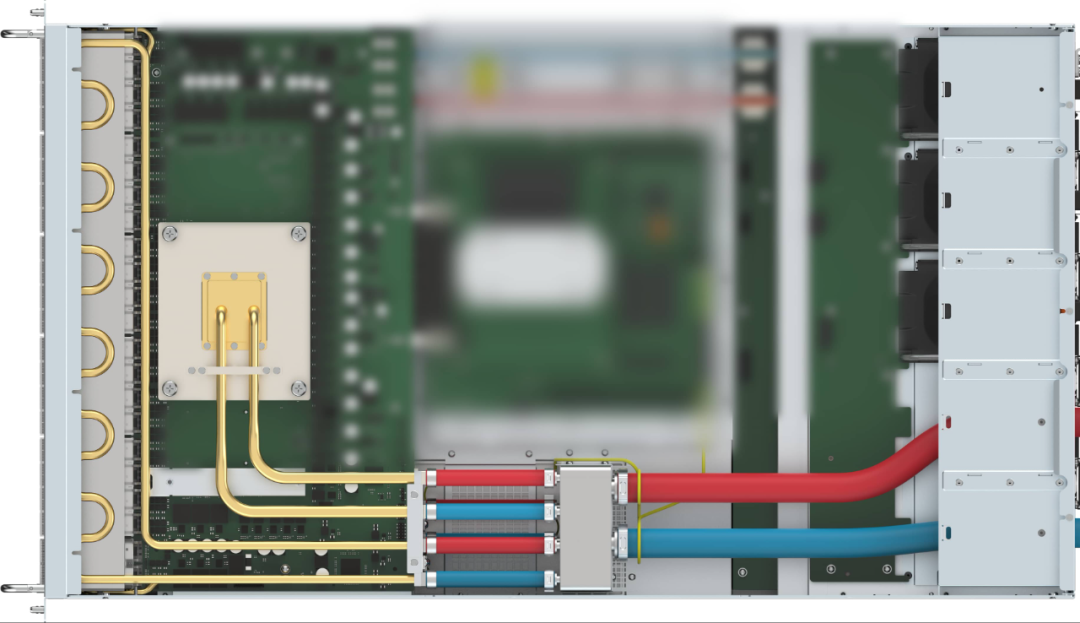

针对难点2:TH5 Liquid Tigatron交换机实现液路和电路分离设计,高风险区漏液不会渗漏到电路板,提升可用性。

针对难点3:采用铝板嵌水管的低成本方案,支持多个2x4 stack cage上、下层optics级联液冷,解决行业难点(一块冷板覆盖22个光模块,保障所有模块良好接触散热,且插拔50~100次后热性能不下降)。

液冷除了带来冷,还有什么?

液冷,可不仅仅是个简单的散热手段,它更像是网络设备领域“创新引擎”的润滑剂。

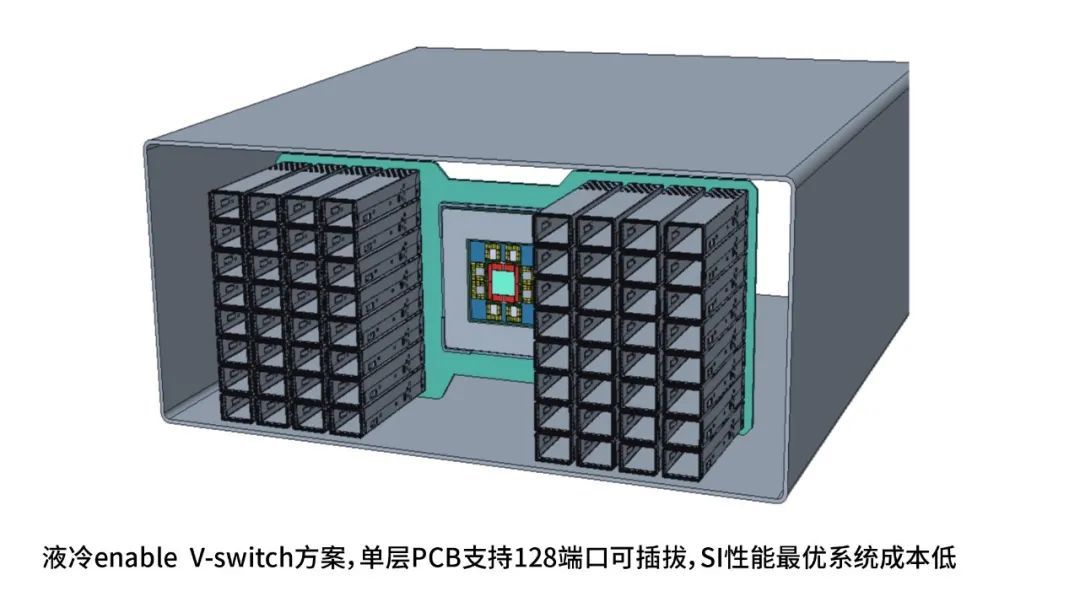

比如:最近流行的CPO “缓蚀剂” Vertical Switch设计,需要液冷加持才能持续演进。

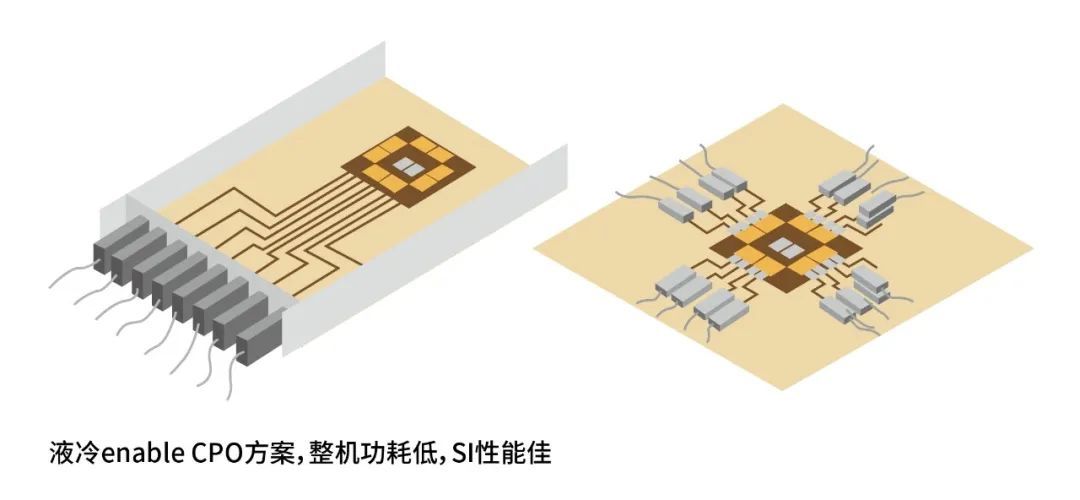

还有行业内多年备受争议的CPO交换机:冷板式液冷更是强制需求套装。

液冷时代即将到来!

液冷即将迎来更大规模市场爆发,一起见证更多液冷设计案例涌现。